3Dモデルのアバターで活動するVTuberの方もそこそこ居ると思います。

その中でも表情がより細かく反映できるのがパーフェクトシンク対応モデルです。

対応したアバターと対応したアプリが必要になりますが、両方揃えればかなり表情豊かになるので配信や動画のクオリティが高くなります。

この記事を読めば、VRMアバターのパーフェクトシンク化の簡単なやり方が分かります!

目次

パーフェクトシンクって何?

めちゃくちゃ簡単に言うとアバターの表情筋を強化するみたいなイメージになります。

FaceIDに対応している端末で表情を読み取って、アバターに反映させていきます。

ARKitを利用したものなので、基本的にはiOSでしか実現できません。

が、最近はandroidでも同様に表情豊かなアバター表現をできる仕組みもできてきました。

今回のところは従来のパーフェクトシンクについて解説をしていきます。

パーフェクトシンク対応に必要なもの

VRoidで出力したVRMアバター

本質的にはVRoid産であることは必須ではありません。

ただ、今回はパーフェクトシンク対応アバターに簡単に変換するアプリを利用する方法の解説です。

アプリ側がVRoid産のVRMにしか対応していないので、今回はVRoid産のアバターを用意する必要があります。

初心者でも3Dアバターが簡単に作れる!?VRMモデル制作アプリVRoidの導入方法と解説

HANA_APP

Boothで販売されているアプリです。

自分でUnityを使って設定できるのであれば無料ですが、こちらのアプリは1,500円です。

手間を考えると安いくらいの価格設定だと思います。

FaceID対応の端末

iOSのFaceID対応端末が必要です。

タブレットでも利用できますが、大きいとカメラとして使うには不便なのでiPhoneを推奨します。

普段使いのスマホとは別に用意するのであれば、カメラ用と割り切って型落ちモデルの中古品などを安く購入するのもありです。

Face ID に対応している iPhone と iPad のモデル

iFacialMocap

ストアで販売されている有料のアプリです。価格は$7.99です。

FaceID対応端末で読み取った表情のデータを対応しているアプリに送信します。

実際に対応したアバターを動かすためには必須です。

パーフェクトシンク対応のアバターを動かすアプリ

iFacialMocapのデータを受け取ってアバターに反映させるアプリを利用する必要があります。

具体例としてはLuppetやVMagicMirror、3teneなどがあります。

有料のものもあれば、無料のものも存在しますので、自分の環境ややりたい事に合わせて選択しましょう。

VRMアバターをパーフェクトシンク対応にして動かしてみよう

HANA_APPの購入

BOOTHで販売されているので購入します。

私の画面だと「購入済み」になっている部分にカートに入れるボタンが表示されるので、そこから購入できます。

購入するとアプリをダウンロードできます。

ZIPファイルになっているので、任意の場所にダウンロードして解凍します。

HANA_APPを起動してアバターを変換しよう

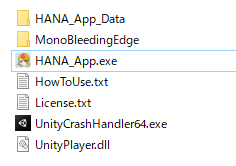

解凍するとこんな感じのファイルがあります。

HANA_App.exeを実行すれば起動してきます。

起動するとめちゃくちゃシンプルな画面になります。

アバター選択からVRMファイルを読み込むか、読み込みたいVRMファイルを直接ドラッグ&ドロップすると画面が切り替わります。

とりあえずパーフェクトシンク化するには、左下のボタンをクリックすればOKです。

ボタンをクリックするとアバターの性別を選択する画面が表示されます。

男性アバターなら左の「Male」女性アバターなら右の「Female」をそのままクリックすれば変換されます。

変換が完了したらSaveでパーフェクトシンク対応したVRMアバターを出力できます。

出力したアバターの表情がおかしい場合はClip調整を見て調整してみてください。

iFacialMocapを購入しよう

iFacialMocapはストアで販売されています。

カメラ用にするデバイスでAppStoreからiFacialMocapを検索して購入してしまいましょう。

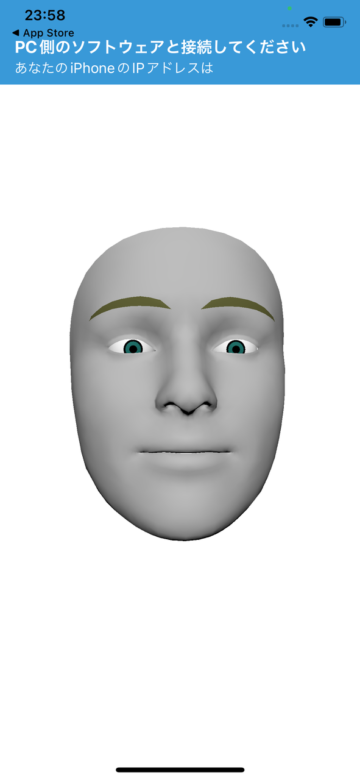

購入して起動すると顔だけのモデルが表示されると思います。

これがきちんと動いていればキャプチャは成功です。

アバターを動かすアプリとの連携は各アプリごとにやり方が異なるので、それぞれの解説を参考に設定しましょう。

対応アプリで実際に動かしてみよう

今回は私が普段から使っているLuppetを参考例として紹介します。

パーフェクトシンク対応したモデルを通常モデルの手順で読み込みます。

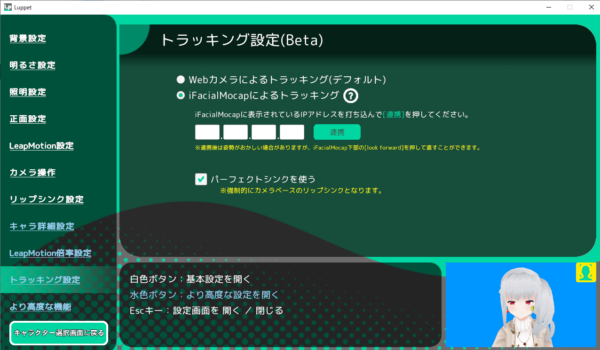

Luppetでは、パーフェクトシンクを活用してモデルを動かすためにはまずメニューを開きます。

「トラッキング設定」を開きます。

デフォルトではWebカメラになっているので、「iFacialMocapによるトラッキング」へ変更します。

iFacialMocap側に表示されているデバイスのIPアドレスを入力欄に打ち込んで「連携」ボタンを押します。

Luppet以外でも対応しているアプリなら、メニューのどこかに同じような項目があると思うので探して入力してください。

顔の向きや姿勢が連携直後にはズレていることがあるので、iFacialMocap側で「look forward」を押すか、何もない部分で画面タップで正面に補正できます。

Comments are closed, but trackbacks and pingbacks are open.